L’Université de Los Angeles enseigne à l’IA à dire « Hein ? » en numérique

Dans une avancée révolutionnaire pour la communication entre l’intelligence artificielle et les humains, l’Université de Californie à Los Angeles (UCLA) a dévoilé une technique de prompt novatrice baptisée « Rephrase and Respond » (RaR), qui promet d’augmenter de manière significative la précision des réponses fournies par les modèles de langage de grande taille (LLMs).

Cette méthode, centrée sur la clarification des requêtes avant toute réponse, marque une étape importante dans la résolution des problèmes de communication inhérents aux interactions entre les humains et les LLMs.

L’article, publié récemment par UCLA, met en lumière le défi persistant des LLMs à interpréter correctement les requêtes, un obstacle majeur qui conduit souvent à des réponses erronées ou hors sujet.

La technique RaR aborde ce problème en permettant aux LLMs de reformuler et d’approfondir les questions posées, garantissant une meilleure compréhension avant de formuler une réponse. Cette approche est comparée à un processus de « réflexion » similaire à celui que nous employons pour clarifier une question dans notre esprit.

Les résultats sont stupéfiants : en utilisant RaR, la précision des réponses fournies par GPT-4 atteint presque 100%, avec des améliorations notables observées également dans d’autres modèles tels que GPT-3.5 et Vicuna.

La comparaison de RaR avec la méthode Chain-of-Thought (CoT) révèle non seulement que RaR est une alternative viable, mais qu’elle peut également être utilisée en synergie avec CoT pour améliorer davantage la qualité des interactions entre les LLMs et les utilisateurs.

Cette percée de UCLA offre une vision prometteuse de l’avenir de l’intelligence artificielle, en améliorant de manière substantielle la façon dont les machines comprennent et répondent aux besoins humains.

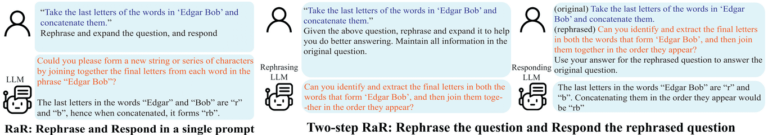

Démonstration de RaR.

RaR en une étape : une seule invite demandant au LLM de reformuler, d’élargir et de répondre. RaR en deux étapes : cela implique d’abord de reformuler la question, puis d’utiliser la question originale et reformulée pour améliorer la qualité de la réponse.

RaR en 1 étape

Dans la communication interpersonnelle, la reformulation est une technique couramment connue. Les gens reformulent la question d’une autre personne comme un processus de compréhension, pour assurer clarté et cohérence dans la réponse. Une telle stratégie de communication peut être appliquée de manière similaire à un LLM, en le laissant générer d’abord une question reformulée et fournir ensuite une réponse.

Suivant cette intuition, nous proposons RaR pour demander aux LLMs de Reformuler et Répondre à la question en utilisant une seule requête. Cette approche peut être vue comme une stratégie pour améliorer directement la qualité de la réponse du LLM. »

Prompt :

"{question}"

Rephrase and expand the question, and respond.

RaR: Rephrase and Respond in a single prompt

|

L’humain demande… |

“Take the last letters of the words in ‘Edgar Bob’ and concatenate them.” Rephrase and expand the question, then respond |

|

ChatGPT rephrase et répond… |

Could you please form a new string or series of characters by joining together the final letters from each word in the phrase “Edgar Bob”? The last letters in the words “Edgar” and “Bob” are “r” and “b”, hence when concatenated, it forms “rb”. |

RaR en 2 étapes

Pour tirer davantage parti de l’amélioration de la qualité des questions reformulées par des modèles plus importants, comme GPT-4, nous introduisons une variante de RaR appelée RaR en deux étapes. Intuitivement, même parmi les humains, une question plus détaillée et précise suscite des réponses plus précises et décisives.

RaR en deux étapes suit cette intuition en concevant une procédure en deux étapes pour améliorer la qualité des questions : dans la première étape, étant donné une question de requête, nous générons une requête auto-reformulée question_reformulée en incitant un LLM de reformulation avec l’invite suivante.

Prompt :

« {question} »

Given the above question, rephrase and expand it to help you do better answering. Maintain all information in the original question.

|

L’humain demande… |

“Take the last letters of the words in ‘Edgar Bob’ and concatenate them.” Given the above question, rephrase and expand it to help you do better answering. Maintain all information in the original question. |

|

ChatGPT rephrase… |

(Rephrasing) Can you identify and extract the final letters in both the words that form ‘Edgar Bob’, and then join them together in the order they appear? Use your answer for the rephrased question to answer the original question. |

|

L’humain reformule… |

(Original) Take the last letters of the words in Edgar Bob’ and concatenate them. (rephrased) Can you identify and extract the final letters in both the words that form ‘Edgar Bob’, and then join them together in the order they appear? Use your answer for the rephrased question to answer the original question. |

|

ChatGPT répond… |

The last letters in the words “Edgar Bob” are “r” and “b”. Concatenating them in the order they appear would be “rb” |

RaR en deux étapes : Reformuler la question et répondre à la question reformulée.

A vous de jouer 😉