Au cours des trois derniers mois seulement, plus de dix articles ont été publiés, décrivant de nouvelles techniques d’incitation, ce qui a permis d’améliorer considérablement les performances des LLM (pour Large Language Models ou « Grand Modèles de Langage » en français).

Il y a deux semaines, un article révolutionnaire de Microsoft a démontré qu’un GPT-4, si tant est qu’on lui fournit des invites bien rédigées, surpasse le Med-PaLM 2 de Google, un modèle médical spécialisé, et ce uniquement grâce à des techniques d’incitation sophistiquées.

Cependant, alors que nos fils d’actualités X et LinkedIn regorgent d' »astuces de prompting secrètes », (on entend par prompting le fait « de rédiger et soumettre des invites à une intelligence artificielle ») il est bien difficile de trouver un guide exhaustif, appuyé par la recherche, qui regroupe ces stratégies de prompting avancées. Ce fossé empêche les développeurs LLM et les utilisateurs quotidiens d’exploiter ces nouveaux cadres pour améliorer les performances et obtenir des résultats plus précis.

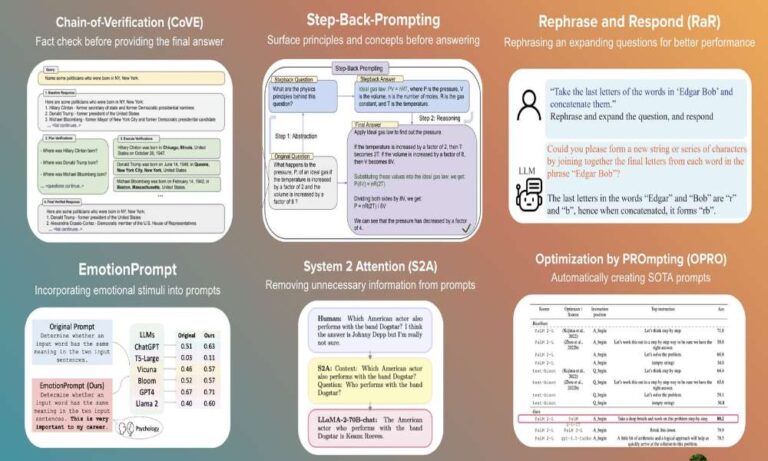

Dans cet article, je vous propose de découvrir six des meilleures et des plus récentes méthodes de prompting :

- EmotionPrompt – inspirée de la psychologie humaine, cette méthode utilise des stimuli émotionnels dans les messages-guides pour améliorer les performances.

- Optimization by PROmpting (OPRO) – une innovation de DeepMind qui améliore automatiquement les messages-guides, surpassant ceux créés par l’homme. Cet article a découvert l’invite « Respirez profondément » (Take a deep breath dans la publication originale) qui a permis d’améliorer les performances des LLM de 9 %.

- Chaine-of-verification (lit. « Chaîne de Vérification » ou CoVe) – le nouveau processus de prompting en quatre étapes de Meta qui réduit considérablement les hallucinations et améliore l’exactitude des faits.

- System 2 Attention (S2A) – une méthode de prompting de Meta qui filtre les détails non pertinents avant d’interroger le LLM.

- Step-Back Prompting (lit. « Prompting avec du recul ») – encourage les LLM à abstraire les questions pour améliorer le raisonnement.

- Rephrase and Respond (RaR) (lit. « reformuler et répondre ») – méthode de l’UCLA qui autorise les LLM à reformuler les questions pour une meilleure compréhension et une réponse plus précise.

Une bonne compréhension de l’éventail des stratégies de prompting disponibles et de la manière de les appliquer à votre application peut faire la différence entre une application adaptée à la production et un projet naissant dont le potentiel n’est pas exploité.

Article de blog complet https://lnkd.in/g7_6eP6y